Spis treści:

Technologische Fortschritte haben es Robotern ermöglicht, Emotionen zu präsentieren. Warum präsentieren und nicht zeigen oder ausdrücken? Während der Ausdruck von Emotionen als Ergänzung zu den Dienstleistungen geschätzt wird, bleibt der Ausdruck echter Emotionen das chemische Rätsel des Lebens. Wir sagen mehr dazu – in der Mensch-Roboter-Interaktion bleiben sogar menschliche Gefühle unerforscht. Da Emotionen jedoch ansteckend sind, suchen immer mehr Roboterbauer mit Hilfe von Algorithmen des maschinellen Lernens, der Biometrie und der Computerlinguistik nach der goldenen Formel, um den perfekten humanoiden Roboter zu schaffen. Das Ergebnis eines dieser Versuche ist Eva.

Was ist der Roboter Eva?

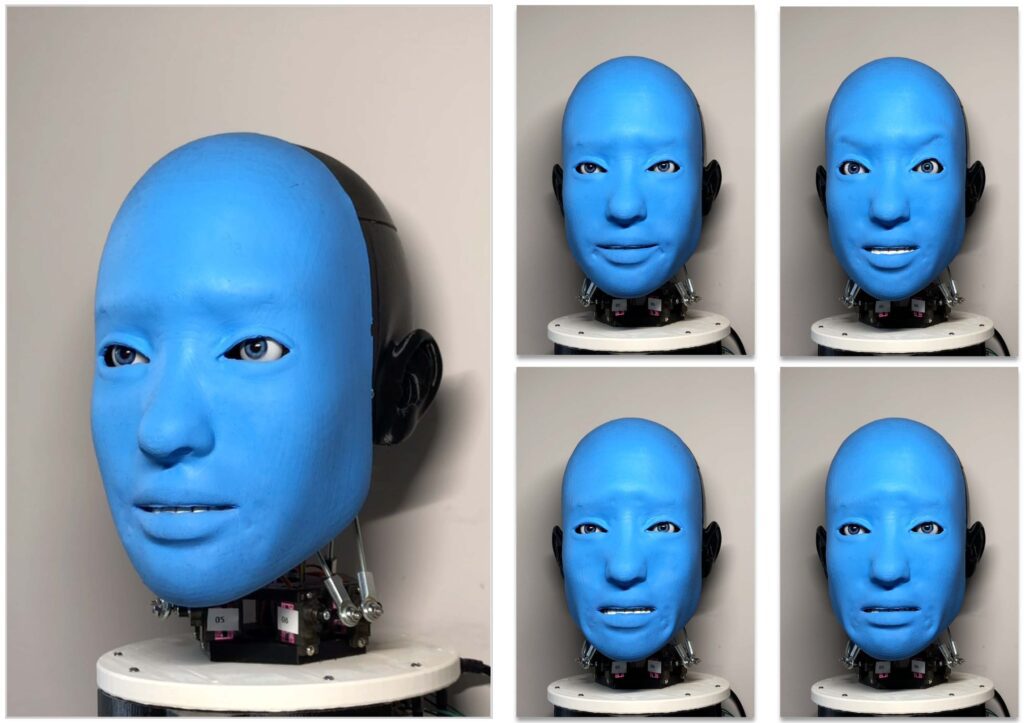

Eva ist ein Robotergesicht, das menschliche Gesichtsausdrücke und -bewegungen realistisch nachbilden soll. Laut einer Ankündigung der Schöpfer des Creative Machines Lab an der Columbia University in New York soll es als Plattform für die Erforschung der künstlichen Intelligenz im Bereich der Mensch-Computer-Interaktion dienen und insbesondere dazu beitragen, das Potenzial der emotionalen Intelligenz von Maschinen zu erforschen. Er ist mit 14 künstlichen Muskeln der Gesichtshaut, sechs Halsmuskeln und fünf Augen- und Lidmuskeln ausgestattet. Eva wird von 25 MG90S-Servomotoren angetrieben und – Achtung, Achtung – von unserem Lieblings Raspberry Pi. Der Entwurf umfasste sogar einen Servo-Hat für den RPi von den renommierten Elektronikspezialisten von Adafruit. Beim Bau des Roboters wurde in gewissem Umfang auch 3D-Druck eingesetzt, genauer gesagt etwa 2,25 kg ABS- und PLA-Filament.

Nach Angaben seiner Schöpfer ist Eva so konzipiert, dass dieser für weniger als 1.000 US-Dollar selbst hergestellt werden kann – vorausgesetzt, man hat Zugang zu ein paar Standardwerkzeugen, einem Laserschneider und einem 3D-Drucker. Der ausgestellte Prototyp wurde auf einem Ultimaker 2+ Extended Drucker gedruckt, es kann jedoch jeder 3D-Drucker verwendet werden, dessen Arbeitsfläche eine Höhe von mindestens 28 cm aufweist.

Gestaltung des Verhaltens

Lassen Sie uns die Emotionen von Robotern genauer untersuchen. Doch bevor wir dies tun können, müssen wir uns mit den Müttern und Vätern der Roboter beschäftigen, nämlich mit uns selbst. Viele Verhaltensweisen werden durch grundlegende kognitive Fähigkeiten bestimmt, die wiederum Aspekte des Sozialverhaltens von Menschen und Tieren beeinflussen. Es liegt auf der Hand, dass Robotiker ihre Roboter gerne mit echten kognitiven Fähigkeiten ausstatten würden. Wenn ein Einzelhändler in einem Geschäft feststellt, dass Verbraucher, die Shampoo kaufen, in der Regel auch Seife kaufen, aber nur, wenn sie einen Gutschein erhalten, wird er in Erwägung ziehen, jedem Kunden, der normalerweise nur Shampoo kauft, einen Gutschein für Seife zu geben. Die allgemeine Absicht einer solchen Aktion ist relativ leicht zu verstehen. Diese Vorgehensweise wird von Unternehmen genutzt, um das Verhalten der Verbraucher unter bestimmten Umständen besser zu verstehen und vorherzusagen. Aber was bedeutet das für die Robotik? Neben der Konstruktion von Eva beschäftigen sich die Forscher der Creative Machines Labs mit dem sogenannten behavioral modelling. Aber reicht es aus, den Begriff “künstliche Intelligenz” ständig und überall einzutippen?

Echte Intelligenz, echtes Bewusstsein. Denn künstliche Intelligenz können wir ja schon erschaffen.

Die Definition von Intelligenz ist in wissenschaftlichen Quellen leicht zu finden. Die meisten Forschungsarbeiten zur Modellierung des Maschinenverhaltens basieren nur auf ausgewählten, parametrischen Sensordaten (die von Sensorendie die Maschine von ihrem Konstrukteur/Entwickler erhalten hat) und “eingebettetem” aufgabenrelevantem Wissen. Creative Machine Labs schlägt vor, dass der Beobachter das Verhalten der Maschine allein durch ihre visuelle Verarbeitung modellieren kann, ohne vorherige symbolische Informationen oder Annahmen über die relevanten Eingangsdaten. Um diese Hypothese zu testen, entwarfen Fachleute ein nonverbales Roboterexperiment, bei dem ein KI-Beobachter die zukünftigen Handlungen eines Schauspielers nur auf der Grundlage eines Bildes vorhersagen sollte, das die Anfangsszene zeigt. Es wurde festgestellt, dass der KI-Beobachter in der Lage ist, die Zukunftspläne des Schauspielers mit einer Erfolgsquote von 98,5 % für vier verschiedene Aktivitäten zu visualisieren. Es wurde natürlich betont, dass diese Aktivitäten der KI vor dem Experiment nicht bekannt waren. Creative Machine Labs stellt fest, dass eine solche visuelle Modellierung von Verhalten eine wesentliche kognitive Fähigkeit ist, die es Maschinen ermöglicht, ihre Umgebung zu verstehen und sich mit ihr zu koordinieren. In diesem Bereich hat die KI im Wettbewerb mit Primaten vorerst nicht die geringste Chance. Oder es funktioniert einfach anders, d.h. … es funktioniert nicht als kognitive Intelligenz.

Symbol grounding problem, also die Träume der KI-Entwickler

Das Problem des symbolischen Verständnisses der Wirklichkeit hängt damit zusammen, wie Wörter (d.h. Symbole) ihre Bedeutung erhalten, und damit mit dem Problem, was Bedeutung selbst eigentlich ist. Das Problem der Bedeutung hängt wiederum mit dem Problem des Bewusstseins zusammen, d. h. mit der Frage, wie es dazu kommt, dass mentale Zustände überhaupt sinnvoll sind. Hier kommen Robotik und Kognitionswissenschaft zusammen. Denn es geht um das, was wir Intentionalität nennen.

Intentionalität ist eine wichtige Fähigkeit, die derzeit bei Robotersystemen fehlt. Ein “Programm” allein kann keine Intentionalität erreichen, denn Programme enthalten die oben genannten formalen Beziehungen, und Intentionalität hängt von kausalen Beziehungen ab. Wie lassen sich die Grenzen der regulären Programme überwinden? Es scheint, dass physische Maschinen, die kausal mit der Welt verbunden sind, interne kausale Kräfte haben müssen. Dann könnten sie die notwendige Kausalität reproduzieren, was ein Ansatz ist, der in die gleiche Richtung geht wie die Arbeiten zur künstlichen Intelligenz. Es ist wichtig festzustellen, dass Roboter nicht mehr nur Roboter sein können, die durch ein System von Symbolen gesteuert werden. Wenn die Eingabedaten nicht von einer Tastatur kommen, über der ein kluger und sachkundiger Mensch gesessen hat, um der Maschine Befehle zu geben, und die Daten nicht von einem Monitor, sondern z. B. von einer Videokamera ausgegeben werden (und wir kennen solche Versuche) und dann an die Motoren weitergegeben werden, dann ist es sowieso egal. Das Symbolsystem ist sich der Änderung noch nicht bewusst. Und auch in diesem Fall hat der Roboter keine beabsichtigten Zustände.

Überzeugende Vortäuschung von Emotionen

Das Interesse an der Entwicklung kreativer Anwendungen für Roboter nimmt weiter zu. Dabei geht es vor allem um solche, die der Unterhaltung, der Geselligkeit oder der Motivation dienen. Die Identifizierung der Merkmale menschlicher Kreativität und die Bestimmung, wie diese Prozesse von Robotern nachgebildet oder unterstützt werden können, bleibt eine offene Frage. Als Enthusiasten aller modernen Technologien sind wir besonders von der transdisziplinären Zusammenarbeit zwischen Künstlern und Ingenieuren begeistert – denn Eva verwendet einen Raspberry Pi Minicomputer, 3D-Druck und elektronische Errungenschaften. All dies kann Aufschluss darüber geben, wie Roboter die Entwicklung neuer Designpfade für interaktive Systeme unterstützen können.

Eva drückt Angst, Abscheu, Traurigkeit, Freude und Überraschung aus. Sie tut dies recht überzeugend, aber es handelt sich dennoch um eine unbeabsichtigte Verarbeitung. Die von den Konstrukteuren beschriebenen Konstruktionsprobleme, die auf der optimalen Platzierung der Sensoren im Roboter beruhen, sind immer noch Ausdruck eines anderen Problems. Ja, Eva lernt tatsächlich – so viel, wie wir dank der heutigen Technologie maschinelles Lernen auf Roboter anwenden können. Er schaut sich Aufnahmen von Menschen an, die Gefühle ausdrücken, wiederholt den Ausdruck durch Ausprobieren und kommt schließlich immer besser mit der natürlichen Art und Weise in Einklang, Gefühle auszudrücken. Aber es ist trotzdem nur eine Anpassung. Ihre Trauer ist nicht dieselbe Trauer wie unser Mitgefühl für den humanoiden Roboter, der in der Testphase geschlagen und getreten wird. Denn dann liegt es hauptsächlich an unserer Natur und teilweise an den realistischen Ergebnissen der Designer. Wissenschaftler in vielen Bereichen entwickeln Software, die Konzepte der darwinistischen Evolution, einschließlich des “Überlebens des Stärkeren”, aufgreift, um KI-Programme zu schaffen, die sich von einer Generation zur nächsten ohne menschliches Zutun verbessern, aber das ist nur High-Tech-Puppenspiel.

Wie hilfreich war dieser Beitrag?

Klicke auf die Sterne um zu bewerten!

Durchschnittliche Bewertung 4.3 / 5. Stimmenzahl: 6

Bisher keine Bewertungen! Sei der Erste, der diesen Beitrag bewertet.